Técnicas SEO

Las Técnicas SEO hacen referencia al conjunto de prácticas que se utilizan para optimizar el posicionamiento en buscadores. En el vídeo «The SEO process» aprenderás más sobre estas prácticas.

Fuente: The SEO process by Digital Garage at https://www.youtube.com/watch?v=qt_NZdXbksM&t=1s. License by owner of copyright.

Podemos establecer, en función del ámbito al que se aplican, estos grandes apartados:

Técnicas generales de SEO

Las técnicas generales SEO recogen un conjunto de protocolos de carácter global que siguen la forma de comportarse los buscadores y, por tanto, debemos considerar de manera integral en la mejora de posicionamiento de cualquier sitio web. Estas incluyen la optimización de palabras clave, la arquitectura del sitio, la velocidad de carga, la experiencia de usuario (UX) y el SEO técnico, asegurando que el sitio cumpla con las directrices técnicas, como el uso de datos estructurados y la optimización de la arquitectura del sitio.

Técnicas específicas de sitio

Las técnicas específicas de sitio recogen procedimientos que son aplicables de manera global a un sitio web, o lo que es lo mismo, que debemos tener en cuenta de modo global a la hora de diseñarlo. Esto incluye la responsividad, asegurando que el sitio sea accesible y usable en dispositivos móviles; la seguridad del sitio, mediante la implementación de HTTPS para mejorar la seguridad y la confianza del usuario; y el mapa del sitio, incluyendo un sitemap.xml para ayudar a los motores de búsqueda a indexar todas las páginas del sitio. Además, se considera esencial el SEO local, optimizando para búsquedas locales e incluyendo la gestión de perfiles en Google My Business.

Técnicas específicas de página

Las técnicas SEO específicas de página se refieren a todos aquellos procedimientos que deben seguirse en la elaboración de cada página con el fin de garantizar su mejor posicionamiento en los buscadores.

Normalmente, a la aplicación del conjunto de estas técnicas se les denomina como One-Page, y suponen, básicamente, incluir información relevante en las principales etiquetas de la cabecera de un fichero HTML. Estas técnicas incluyen la optimización de metaetiquetas, asegurando títulos, descripciones y etiquetas de encabezado (H1, H2, etc.) bien optimizadas; el contenido relevante y de calidad, asegurando que el contenido sea único, relevante y útil para los usuarios; las etiquetas alt para imágenes, proporcionando descripciones adecuadas en las etiquetas alt de las imágenes para mejorar la accesibilidad y el SEO; y el SEO para búsquedas por voz, adaptando el contenido para responder a consultas realizadas mediante asistentes de voz.

Técnicas SEM (Search Engine Marketing)

Las Técnicas SEM (Search Engine Marketing) se encargan, a partir de los procedimientos generales SEO, de promover el posicionamiento, la visibilidad y la “encontrabilidad” en los resultados ofrecidos por los sistemas de recuperación de información de sitios o contenidos desplegados en Internet, mediante diferentes técnicas de eMarketing.

Estas técnicas incluyen los enlaces patrocinados, utilizando Google Ads y otras plataformas de pago para anuncios; la publicidad contextual, mostrando anuncios en función del contexto del contenido que está visualizando el usuario; la inclusión patrocinada, pagando para que el contenido aparezca en lugares destacados de los resultados de búsqueda; y las estrategias de backlinking, obteniendo enlaces de retroceso de sitios web relevantes y de alta autoridad.

Técnicas SEO generales

Las técnicas generales SEO recogen un conjunto de protocolos de carácter global que indica cuál es la forma de comportarse los buscadores y, por tanto, debemos considerar de manera integral en la mejora de posicionamiento de cualquier sitio web. Esto incluye la optimización de palabras clave, la arquitectura del sitio, la velocidad de carga, la experiencia de usuario (UX) y el SEO técnico, asegurando que el sitio cumpla con las directrices técnicas, como el uso de datos estructurados y la optimización de la arquitectura del sitio. Además, la inteligencia artificial (IA) y el aprendizaje automático están cobrando importancia en el análisis y comportamiento de los motores de búsqueda, así como las Core Web Vitals como métricas clave para la evaluación del rendimiento de un sitio.

Fuente: Intro to search engine optimisation (SEO) by Digital Garage at https://www.youtube.com/watch?v=stHBZGm_hMo&t=1s. License by owner of copyright.

Enlaces entrantes

Como ya hemos visto, los buscadores privilegian los enlaces. No en vano, es ese el modo por el que son capaces de recorrer la topografía de la Web. Son sus vías de reconocimiento y los canales a través de los cuáles mapean el tamaño y dimensiones de la Red.

Los programas de análisis de los buscadores son cada vez más sofisticados, por lo que debemos, además de acumular enlaces, tener en consideración otras cuestiones vinculadas respecto a la calidad de estos:

- Los enlaces que proceden de dominios Top-level (.es, .edu, .org…) tienen más relevancia que los que apuntan desde otros dominios o subdominios.

- El dominio del que proceden los enlaces, o a los que apunta, es muy relevante. Todos los enlaces no tienen el mismo peso. Por ejemplo, comparando la dirección IP de alguien que da links con la dirección IP de quien recibe ese link. Si al hacerlo se comprueba que ambas direcciones coinciden en el bloque C (la tercera parte, o sea, la penúltima, de las cuatro que forman el número IP), lo más probable es que ambas direcciones vengan del mismo proveedor e, incluso, tal vez del mismo servidor. En ese caso, el buscador devaluará el valor de esos enlaces.

- Las redes naturales de enlaces, es decir, aquellas que siguen patrones lógicos de crecimiento, de relación temática, etc. son privilegiadas frente a aquellas otras que parecen artificiales (intercambio o compra de enlaces, granjas de enlaces…)

Medidas vinculadas con los enlaces: número y calidad

Si los enlaces poseen tal importancia, es lógico que se hayan establecido distintas métricas que pongan en valor una página o un sitio web en función de cuántos enlaces apuntan a ella y la calidad que estos poseen. Entre otros muchos factores, la calidad vendrá determinada, a su vez, por el valor que posee cada una de las páginas o sitios desde los que apuntan esos enlaces.

El algoritmo HITS mide la importancia de un documento en la Web, tomando como referencia la importancia de los sitios web en los que aparece citado, referido o enlazado. La relevancia se obtiene considerando dos categorías de sitios web relevantes:

- “Hub”: Sitios muy enlazados (como los directorios DMOZ, Google, etc.) y que, a su vez, enlazan a sitios considerados importantes. Normalmente, además, poseen administradores que evalúan la calidad de los enlaces, lo que supone una garantía añadida para los buscadores.

- “Authority”: Sitios que representan, en versión digital, el concepto de la autoritas latina; es decir, sitios web que representan para muchos (y lo demuestran la cantidad de enlaces que apuntan a ellos) una referencia indiscutible en un tema dado. Aquellos enlaces que apuntan desde estos sitios son especialmente valorados.

Backlinks o Inbound links muestra el número de enlaces que se dirigen a una página web determinada. Por tanto, resulta fundamental conocerla, y mejorarla, porque es un índice básico de la calidad SEO de nuestro sitio y, en consecuencia, del valor de nuestro dominio. Cada buscador utiliza una sentencia distinta para conocer el número de backlinks. Por ejemplo, en Google, se debe poner en la caja de búsqueda: link:URL a evaluar

Además, herramientas modernas como Ahrefs, Moz, y SEMrush son esenciales para el análisis y monitoreo de backlinks.

Actualización de información

Los motores de búsqueda privilegian aquella información que está actualizada.

Después de todo, esto parece lógico. Los buscadores quieren ofrecer los resultados que satisfagan de la forma más eficaz las preguntas de quienes confían en ellos para encontrar información, servicios, etc., por lo que es razonable pensar que aquello que esté actualizado pueda ponderarse mejor. La frescura del contenido y la frecuencia de actualización juegan un papel crucial en mantener la relevancia y la visibilidad en los resultados de búsqueda.

Antigüedad de dominios

La antigüedad de un dominio es un factor estructural de posicionamiento. La antigüedad es una garantía de valor para los buscadores, como lo son las marcas consolidadas.

Por otra parte, las malas prácticas SEO, o lo que es lo mismo, el deseo de engañar a los motores de búsqueda posicionado de manera alterada un dominio en los resultados orgánicos del SERPs, ha hecho que estos tomen medidas para evitarlo, y una de ellas es favorecer aquellos dominios de larga duración: los “Crianza” y “Reservas” de buena añada.

Google aplica su Sandbox a los dominios nuevos. Se trata de un filtro que trata de evitar que los sitios web de reciente creación puedan obtener un posicionamiento clave de sus palabras clave en las SERPs, independientemente de que posea una buena optimización y/o numerosos backlinks. Se trata de eludir la actuación de los spammers y las prácticas Black Hat SEO.

En los últimos años han crecido los parking de dominios, portales dedicados a la compra, subasta y reventa de dominios con un buen SEO y un alto valor en las principales métricas (Domain Authority de Moz, Domain Rating de Ahrefs…).

Conclusiones

- Se debe sacar el máximo partido a los dominios consolidados

- Evitar cambiar de dominio (aunque sean leves cambios de nombre

- Cuando se realizan campañas específicas, salvo que se requiera realmente, puede ser preferible utilizar un subdominio que crear un dominio nuevo desde cero.

Buen servicio de hosting

La web está llena de ofertas mareantes para alojar nuestro sitio web, con prestaciones casi ilimitadas a precios muy bajos. Sin embargo, debemos ser cautelosos, ya que no siempre lo barato es bueno.

Es crucial prestar atención al servicio de alojamiento que contratamos para nuestro sitio web. Existen numerosas opciones (hosting compartido, dedicado, servidores virtuales VPS, housing…), y lo importante es elegir la que mejor se adapte a nuestras necesidades.

La importancia del servicio de hosting desde la perspectiva del SEO es considerable. La fiabilidad del servicio (tolerancia a errores, nivel de disponibilidad, gestión de backups, servicio técnico y soporte) y, especialmente, el tiempo de espera y de respuesta para mostrar el sitio (es decir, cuánto tiempo tarda en responder y cargar una página solicitada por un usuario) son cruciales. Los buscadores prefieren sitios con menores tiempos de respuesta, valorándolos mejor en los resultados de búsqueda. Además, la localización del servidor puede influir en el rendimiento del sitio en diferentes regiones geográficas, afectando el SEO local.

Buen contenido

Aunque la metáfora del tránsito de la Web nos lleva por playas en las que se surfea y mares apacibles en los que navegar, lo cierto es que la mayor parte de los internautas son auténticos exploradores con objetivos muy específicos. Esto no va en contra de la serendipidad que puede embargar cualquier exploración en la web, pero sí nos indica que los usuarios buscan, directa o indirectamente, información y servicios que puedan satisfacer necesidades concretas.

Normalmente triunfan aquellos sitios que cubren esa demanda mediante buenos contenidos, materiales de calidad y servicios de alto valor añadido. Es evidente que esto supone tiempo, esfuerzo y recursos; sin embargo, es mejor tener poco contenido de alta calidad que mucho contenido de escaso valor. La calidad se recompensa con accesos, los accesos generan enlaces, los enlaces aumentan el SEO, y el SEO genera confianza y valor en nuestros sitios. Además, es importante estructurar bien el contenido y utilizar elementos multimedia (imágenes, videos, infografías) para mejorar la experiencia del usuario y la retención de la información.

Estar en directorios de referencia

Ya nos hemos referido a la volatilidad de la Web anteriormente. Esta, unida a su carácter abierto, hace que las fuentes de autoridad estén mucho más dispersas y sea más difícil evaluar el valor real de la información. Por esta razón, los buscadores confían en determinados directorios y sitios de referencia que actúan como fuentes privilegiadas. Es importante estar indexados en estos directorios para aumentar la autoridad de nuestro sitio.

Aunque uno de los principales directorios de referencia, el Open Directory Project (DMOZ), fue cerrado en 2017, existen otros directorios y sitios de alta autoridad que pueden ser útiles. Por ejemplo, Google My Business para negocios locales, Yelp, y directorios específicos de la industria o el nicho del sitio. Además, la participación en redes sociales y plataformas de contenido (como Medium, LinkedIn, y otros) puede ayudar a establecer la autoridad y aumentar la visibilidad en los motores de búsqueda.

Técnicas del sitio

Las técnicas generales de SEO incluyen procedimientos aplicables de manera global a un sitio web, lo que significa que deben considerarse durante toda la fase de diseño. En el vídeo «The importance of an SEO plan» se explica la importancia de contar con buenos procedimientos para diseñar un sitio web centrado en el usuario.

Fuente: The importance of an SEO plan by Digital Garage at https://www.youtube.com/watch?v=TpG8lO6Rnp4&t=6s. License by owner of copyright.

Core Web Vitals: Mejorar los indicadores de calidad del sitio

Los buscadores privilegian los sitios que ofrecen una buena experiencia de usuario. Tras años de experiencia utilizando diferentes sistemas y medidas, Google ha establecido un modelo unificado de indicadores de calidad, las Core Web Vitals, con el objetivo de establecer un modelo unificado y sencillo de generar informes de rendimiento del sitio web, y, con ello, facilitar a los desarrolladores una manera más sencilla de abordar la mejora de sus sitios.

Actualmente, las Web Core Vitals se centran en tres ámbitos de la experiencia de usuario:

- Carga.

- Interactividad.

- Estabilidad.

Carga

El tiempo que tarda en cargarse los diferentes ficheros que arman la página y, por tanto, debe esperar el usuario para que esté disponible el contenido.

La métrica asociada es el LCP (Largest Contentful Paint) que «se refiere al tiempo para el despliegue del contenido más extenso. LCP por sus siglas en inglés, mide el rendimiento de carga. Para proporcionar una buena experiencia de usuario, el LCP debe producirse dentro de los 2,5 segundos desde que la página comienza a cargarse.» (Web.dev)

Fuente: Largest Contentful Paint (LCP) by Philip Walton at https://web.dev/lcp/. Licensed under the terms of the CC BY 4.0.

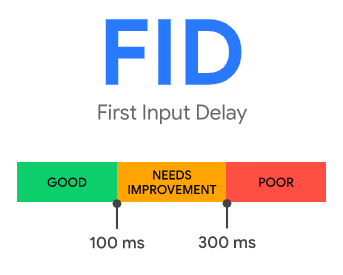

Interactividad

Los usuarios interaccionan con las páginas, por lo que el tiempo que se dispone de los elementos necesarios para hacerlo es fundamental. La métrica asociada es el First Input Delay (FID) que «se refiere a la demora para la primera entrada, FID por sus siglas en inglés, mide la interactividad. Para proporcionar una buena experiencia de usuario, las páginas deben tener un FID de menos de 100 milisegundos.» (Web.dev)

Fuente: First Input Delay (FID) by Philip Walton at https://web.dev/fid/. Licensed under the terms of the CC BY 4.0.

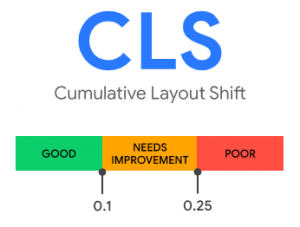

Estabilidad

Una buena experiencia de usuario pasa porque los elementos estructurales de la página sean estables, y que cualquier cambio en el diseño debido al carácter progresivo de la carga, no altere, por ejemplo, las posiciones de los botones, enlaces u objetos sobre los que interaccionamos. Lo molesto que resulta esto se entiende bien desde la experiencia que tenemos en muchos periódicos, cuando los accedemos desde el móvil, y la carga de elementos de publicidad va desplazando los objetos de manera que, cuando pulsamos en un sitio se ha cargado algo de manera inesperada y estamos accediendo a un lugar diferente al que deseamos.

Esta métrica, Cumulative Layout Shift (CLS) busca evitar que esto suceda, y «se refiere al cambio acumulativo en el diseño CLS por sus siglas en inglés, mide la estabilidad visual. Para proporcionar una buena experiencia de usuario, las páginas deben mantener un CLS de menos de 0,1.» (Web.dev)

Fuente: Cumulative Layout Shift (CLS) by Philip Walton and Milica Mihajlija at https://web.dev/cls/. Licensed under the terms of the CC BY 4.0.

Resultados esperados

Obtener un buen resultado en las Core Web Vitals supone alcanzar, al menos, el umbral del percentil 75 de cargas de página, segmentado en dispositivos móviles y de escritorio.

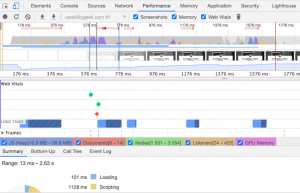

Testear y testear

Obtener un buen resultado en las Core Web Vitals supone alcanzar, al menos, el umbral del percentil 75 de cargas de página, segmentado en dispositivos móviles y de escritorio.

Para comprobar el cumplimiento de estos resultados debemos realiza test del sitio web con aplicaciones como PageSpeed de Google o el Lighthouse de las herramientas de desarrolladores del navegador.

Fuente: Test My Site by Google at https://www.thinkwithgoogle.com/. License by owner of copyright.

Generar palabras clave adecuadas

Valiéndonos del aforismo de Mark Twain, podemos decir que la diferencia entre una palabra clave adecuada y una que es casi adecuada es la misma que entre un rayo y una luciérnaga. Parte de los estudios SEO se dirigen a descubrir, para cada caso, cuál es el rayo y cuál es la luciérnaga. Aunque no tenemos una bola de cristal, contamos con ciertas técnicas y muchas herramientas que nos ayudan en esta tarea.

La búsqueda por palabra clave ha evolucionado con el tiempo. Se ha pasado de una búsqueda basada en una sola palabra a búsquedas más complejas que incorporan varias palabras e incluso frases completas.

Para lograr buenas palabras clave, es útil seguir estos consejos:

- Ponerse en el lado del usuario, pensando en el problema que pretende resolver y la manera en la que lo describiría.

- Focalizar el elemento fundamental que ofrece nuestro sitio.

- Focalizar el público objetivo y cómo realiza sus búsquedas.

- Potenciar los elementos diferenciales y compararnos con la competencia, evaluando qué palabras clave utilizan.

- Considerar que los buscadores diferencian entre palabras clave en plural o singular, o que están escritas juntas o por separado (socio económico o socioeconómico).

- Tener en cuenta las diferencias lingüísticas regionales, dialectales, los argots y los lenguajes técnicos que puedan estar vinculados con nuestros públicos objetivos.

- Seleccionar palabras clave que sean utilizadas en el texto de la página.

- Aunque los buscadores tienden a obviar palabras como artículos, preposiciones y adverbios, según el tema que tratemos, conviene asegurarse sobre cómo se comportan los buscadores en cada caso; se recomienda hacer pruebas.

- Ordenar las palabras clave por relevancia, ya que las primeras siempre son las más importantes para los buscadores.

Es importante no sobreoptimizar el sitio cargando una lista indefinida de términos clave. Nuestras palabras clave deben ser eficaces y apuntar a la diana. Se suele recomendar una horquilla de entre 6 y 12 palabras clave como número óptimo. Generar cierta redundancia de las palabras clave en diferentes elementos de la página también será positivo.

Optimizar el texto visible

Entendemos como texto visible todo aquello que el navegador puede mostrar (se excluyen, por tanto, la información de cabecera de los ficheros html, etc.)

Los buscadores penalizan la inserción de texto en una página que no pueda visualizar el navegador, bien porque se oculta con el mismo color de un fondo (texto rojo sobre fondo rojo, etc.), mediante plantillas de estilo trucadas, capas fijas de color, etc. Como no les gusta lo penalizan, y tarde o temprano descubren el truco. El consejo: ¡no hacerlo!

Optimizar la densidad de palabras clave

Para conocer cuál es el foco temático de una página los buscadores contabilizan las palabras incluidas en la misma. Con ese recuento, sacan estadísticas y definen cuáles son los ejes, o palabras clave, que marcan el contenido de la misma.

La relación que se establece entre las veces que aparece una palabra en una página y el número total de palabras es lo que se conoce como densidad de palabras clave.

A simple vista, podría parecer que cuanto mayor es ese número, mejor. Pero los buscadores están precavidos ante prácticas fraudulentas, y cuando creen que se está realizando stuffing (es decir, plagando un texto de una determinada palabra de manera forzada) penalizan a la página.

El valor idóneo actualmente para una densidad de palabras clave oscila entre el 3 y el 4%.

Es importante comprobar que ese el valor máximo (o en torno a él) de la palabra o palabras foco, y que no hay otras que, accidentalmente, superan dicha cifra, pues de otro modo el buscador tomará a aquellas como más relevantes.

Dar semántica a las páginas del sitio

Es muy valioso marcar adecuadamente los elementos de todas las páginas. Ello facilita la indexación semántica de los distintos elementos de un sitio.

Los títulos deben estar marcados como tales (<H1>, <H2>…), las listas numeradas y sin numerar, las citas… Todas, independientemente del diseño, deben aplicarse para definir la estructura correcta del documento. Los buscadores lo agradecerán, y los resultados de nuestros sitios, también.

Optimizar el nombre de dominio

El nombre de un dominio (la URL) es el primer elemento de “reputación digital”. Debemos concederle una importancia capital, ya que en él radica buena parte de nuestro éxito.

Cuando sea viable, incluir la palabra clave principal en el dominio ayudará enormemente a mejorar la visibilidad del sitio en los buscadores.

Hacer nuestra página accesible: incluir etiquetas ALT para todos los elementos no textuales

Los buscadores son usuarios “ciegos”. Cuando encuentran por ejemplo una imagen son capaces de reconocer que está ahí, pero poco más; salvo que esta tenga un texto alternativo que explique su contenido, no podrán indexar la información que contiene o representa dicha imagen. Esto mismo, vale para cualquier elemento no textual.

Técnicas SEO específicas de página

Las técnicas SEO específicas de página se refieren a todos aquellos procedimientos que deben seguirse en la elaboración de cada página con el fin de garantizar su mejor posicionamiento en los buscadores.

Normalmente, a la aplicación del conjunto de estas técnicas se denominan como One-Page, y suponen, básicamente, incluir información relevante en las principales etiquetas de la cabecera de un fichero HTML. Señalamos, aquí, solamente las más importantes.

Etiqueta Title

<title>Comunicación Digital: Espacio de aprendizaje</title>

- Es especialmente importante presentarle atención. En los gestores de contenidos, como WordPress, tendremos un plugin específico (como Yoast) para establecer el título de la página.

- Además de ser la primera, es la que muestra en el navegador (línea de cabecera) el nombre de la página, y, por tanto, la que toman como referencia inicial los buscadores, además de que es el nombre que se registra en bookmarks, etc.

- El título debe ser especialmente descriptivo, suficiente y claro, e incorporar, siempre que se justifique, la palabra clave foco de nuestro sitio.

- Conviene que el título no sea especialmente largo (no más de 60 caracteres), y que las palabras más importantes o palabras clave vayan al principio.

Etiqueta Description

<meta name=”description” content=”Espacio de aprendizaje sobre Comunicación Digital de la Universidad Rey Juan Carlos de Madrid y el Grupo Ciberimaginario”>

- Dentro del grupo meta-tags, la primera etiqueta es Description, en la que se incluye un breve resumen (abstract) del contenido de la página.

- Es muy importante que el contenido incluido en la descripción sea especialmente preciso, y responda al contenido de la página. De otro modo, Google obviará esta información y generará su propio resumen.

Etiqueta Keywords (Obsoleta)

<meta name=”keywords” content=”revista, comunicación, multimedia, ciberperiodismo, urjc, periodismo electrónico, periodismo digital”>

- Esta etiqueta pertenece al grupo meta-tags y solía incluir las palabras clave seleccionadas. Sin embargo, Google y otros motores de búsqueda ya no utilizan la etiqueta Keywords para el ranking de páginas. Aunque no hace daño incluirla, no tiene impacto en el SEO actual y puede omitirse.

Etiqueta Robots

<meta name=”robots” content=”index, follow”>

- Dentro del grupo meta-tags, la etiqueta Robots ofrece información a los motores de búsqueda sobre qué se quiere que hagan con la página, con la combinación de dos instrucciones: Index (la página a la que apunta) y follow (si el robot debe rastrear los vínculos de esa página o no)

Etiqueta Canonical

<link rel=»canonical» href=»https://www.ejemplo.com/pagina-principal»>

- La etiqueta canonical es crucial para evitar problemas de contenido duplicado y para indicar a los motores de búsqueda cuál es la versión principal de una página. Esto ayuda a consolidar señales de enlace para URLs duplicadas o muy similares.

Datos Estructurados (Schema Markup)

- El uso de datos estructurados permite a los motores de búsqueda comprender mejor el contenido de la página. Utilizando el marcado de esquema (schema.org), se pueden añadir datos estructurados a las páginas para mejorar su visibilidad en los resultados de búsqueda con rich snippets.

Optimización para Dispositivos Móviles

- Dado que Google utiliza el mobile-first indexing, es fundamental que cada página esté optimizada para dispositivos móviles. Esto incluye un diseño responsivo, tiempos de carga rápidos y una buena experiencia de usuario en pantallas pequeñas.

Velocidad de Carga

- La velocidad de carga es un factor crucial para el SEO. Utilizar herramientas como Google PageSpeed Insights para identificar y solucionar problemas de rendimiento puede mejorar significativamente el posicionamiento en los motores de búsqueda.

Seguridad del Sitio (HTTPS)

- Asegurarse de que el sitio web utiliza HTTPS en lugar de HTTP es esencial para la seguridad y confianza del usuario. Los motores de búsqueda, como Google, también prefieren sitios seguros y los favorecen en los rankings.

Black Hat SEO

Concepto

Las Black Hat SEO hacen referencia al conjunto de prácticas, estrategias y métodos que se sirven de técnicas no lícitas o fraudulentas para mejorar el posicionamiento en los buscadores. En el vídeo «How does Google handle duplicate content?» podrás descubrir más.

Aunque estas técnicas están muy extendidas en internet, son altamente desaconsejables desde un punto de vista profesional. Además de las consideraciones éticas, los buscadores son cada vez más capaces de detectar y penalizar estas prácticas severamente, mediante el “descarte” de los sitios o una baja representatividad en sus listas de resultados (lo que se conoce como ser suspendido). Por ello, es crucial ser muy precavidos y evitar utilizar, aunque sea por desconocimiento, cualquiera de estas técnicas. Es relativamente sencillo cruzar la línea entre un posicionamiento web legítimo y una práctica incorrecta si no se toman las precauciones adecuadas.

¿Cómo saber cuándo estamos violando las buenas prácticas de posicionamiento y nos estamos adentrando en terrenos pantanosos? Debemos:

- Nunca romper las reglas establecidas por los buscadores.

- No afectar negativamente la experiencia del usuario debido a la aplicación de estas técnicas.

- No presentar contenido generado automáticamente por algoritmos con el propósito de engañar a los buscadores.

Es importante considerar que los motores de búsqueda están utilizando cada vez más la IA y el aprendizaje automático para detectar y penalizar prácticas Black Hat. Esto representa una evolución significativa en la capacidad de los buscadores para identificar y sancionar comportamientos no éticos.

Además, dado que las Core Web Vitals y la experiencia de usuario son cada vez más importantes, debe tenerse en cuenta que las técnicas Black Hat Seo pensalizan estas, son otra razón para evitarse. De hecho, las penalizaciones para las prácticas Black Hat pueden ser severas. Estas incluyen la desindexación del sitio, la pérdida drástica de tráfico orgánico y una significativa caída en los rankings de búsqueda.

Técnicas a evitar

El conjunto de técnicas Black Hat SEO va creciendo a medida que se descubren sus efectos y, como señalábamos, los propios administradores de los buscadores tipifican estas prácticas y comienzan a aplicar “sanciones” a los sitios web en las que se localizan.

Se trata de prácticas poco éticas y especialmente sancionadas por los administradores de los buscadores. Afortunadamente, un poco de sentido común y la revisión con alguna de las diversas herramientas para testar que nuestro sitio o página web no está incurriendo en ninguna mala praxis nos ayudará a evitarlo.

El siguiente esquema muestra las técnicas más habituales:

Fuente: Técnicas más habituales Black Hat Seo by Manuel Gertrudix at https://cibercambio.files.wordpress.com/2021/04/a2eac-blackhatse-1441395690-43.png. Licensed under the terms of the cc-by-2.0.

Sobreoptimización mecánica y tanteo

Consiste en insertar dentro del texto de una página web el mayor número de palabras claves o enlaces. Para ello, se utilizan generadores automáticos que suelen ser, por otra parte, reconocidos tarde o temprano por los analizadores de los buscadores.

Granjas de enlaces

Son páginas alimentadas por generadores automáticos que están llenas de enlaces (habitualmente más de cien, lo que hace que los buscadores comiencen a sospechar) con el objetivo de mejorar el posicionamiento en Google. Aunque esta técnica funcionó durante un tiempo, los buscadores ahora pueden localizar y desestimar rápidamente estas granjas de enlaces.

Saturación de la densidad de palabras clave

Vinculada con la sobre optimización, esta técnica aumenta la densidad de palabras claves de forma artificial por encima de los valores permitidos (normalmente entre el 1% y el 3%) Esta técnica se conoce, también, como Spamming Keywords o Keyword Stuffing. Consiste en repetir, dentro del texto, las mismas palabras claves una y otra vez, por lo que los textos suelen tener estructuras poco lógicas (lo que es fácilmente reconocible por los buscadores) Para evitarlo, conviene redactar adecuadamente, utilizar sinónimos, etc.

Doorway pages

Las páginas traseras o páginas puente son páginas máscara creadas únicamente para los buscadores. Suelen ofrecer información diseñada para mejorar el posicionamiento, ocultando el contenido real del sitio (contenido engañoso, spam) o porque el sitio está desarrollado con tecnología que ofrece problemas para la indexación de los buscadores (flash, frames). Son especialmente penalizadas por los buscadores.

Cloaking

Se trata de una técnica de encubrimiento basada en disponer dos páginas diferentes en función de quién realice la consulta: un navegador o un buscador. Normalmente, las páginas “preparadas” para los buscadores están sobreoptimizadas.

Bait and Switch

Variante del cloaking que consiste en “engañar” al motor de búsqueda generando una página con un contenido determinado, esperar a que el buscador la indexe, y sustituyendo el contenido por otro una vez ha sido indexada.

Copy me

Mediante consultas automatizadas a páginas con buenas posiciones en el ranking, se localizan contenidos de alto valor en la web que incluyan palabras clave de alta rentabilidad comercial, y se duplican literalmente, tratando de “secuestrar” parte del tráfico que obtienen dichos sitios. Esta práctica es especialmente dañina para sitios relevantes, ya que puede generar confusión sobre quién es el verdadero propietario de esos datos.

Alta variabilidad del número de enlaces

Se trata de todas aquellas estrategias que tratan de aumentar el número de enlaces mediante compra o intercambio, creando redes artificiales y forzadas. Su naturaleza hace que la tasa de variación de los enlaces sea muy alta, por lo que hace sospechar a los buscadores que están pendientes de cuestiones como el promedio de enlaces que recibe un sitio, el aumento o disminución de links, etc.

Cambios incoherentes de tema

Los spammers realizan búsquedas sistemáticas de dominios que hayan quedado “libres” y que tengan un buen posicionamiento, para adquirirlos y/o venderlos/subastarlos o colocarlos en parking de dominios en plataformas como Sedo. Una vez se venden, esos dominios cambian normalmente de tema, por lo que comienzan a perder enlaces y ponen en alerta a los buscadores.

Hacking

Se trata de un “secuestro” de las posiciones de las páginas aprovechando algún sistema de redireccionamiento que tenga nuestro sitio web (como por ejemplo, cuando hay algún tipo de contador de clics intermedio) de forma que se modifica ese redireccionamiento en beneficio de la página o sitio “secuestradora”.

Enlaces a páginas dudosas

Los enlaces a páginas de contenido dudoso (Bad pages) son peligrosos, especialmente si se trata de sitios que puedan estar en listas negras de los buscadores.

Enlaces rotos

Las páginas poco cuidadas y que incluyen enlaces rotos son penalizadas por los buscadores. No en vano, como hemos visto, los enlaces son el camino natural de reconocimiento de estos. Conviene revisar adecuadamente que todos los enlaces de nuestros sitios funcionan adecuadamente.